記得Office小幫手嗎,只要用過Windows Office 97~2002的人,幾乎都見過這個長著一對眼睛的迴紋針。事實上這個只會問:「請問您想要執行什麼工作?」卻幾乎毫無幫助的迴紋針,用的即是「貝氏演算法」,與啟蒙現代人工智慧的「貝氏網路」屬同一理論架構。現今跟著人工智慧技術飛升,而有水漲船高的「自然語言處理(NLP)」能力、現代真正有用的「虛擬個人助手(VPA)」,如亞馬遜(Amazon)的Alexa、Google的Google Assistant和蘋果(Apple)的Siri,反在科技市場上變得「居家必備」了。

全球最具權威的IT研究與顧問諮詢公司Gartner在兩年一度的資訊展上,於2016年列出十大未來科技重點,其中有句大話:「2020年,30%的網際瀏覽將會不需要螢幕」,間接指涉了智慧語音技術的大未來。這代表「聲音優先(voice-first)」現象會出現,眼和手的功能將大幅減低,你的智慧語音助理能「無所不在」地陪伴你:無論你在開車、行走、社交或運動。你第一次做糖醋魚?隨時開口就有食譜,食材不夠?立即幫你查最近的食品零售商,直接接通自動下單,對方問要不要統編?三秒後Google Assistant猜你在炸魚,沒空馬上回話,直接依你習慣幫你回答,回答時還「呃(uh),」才說「不用好了。」

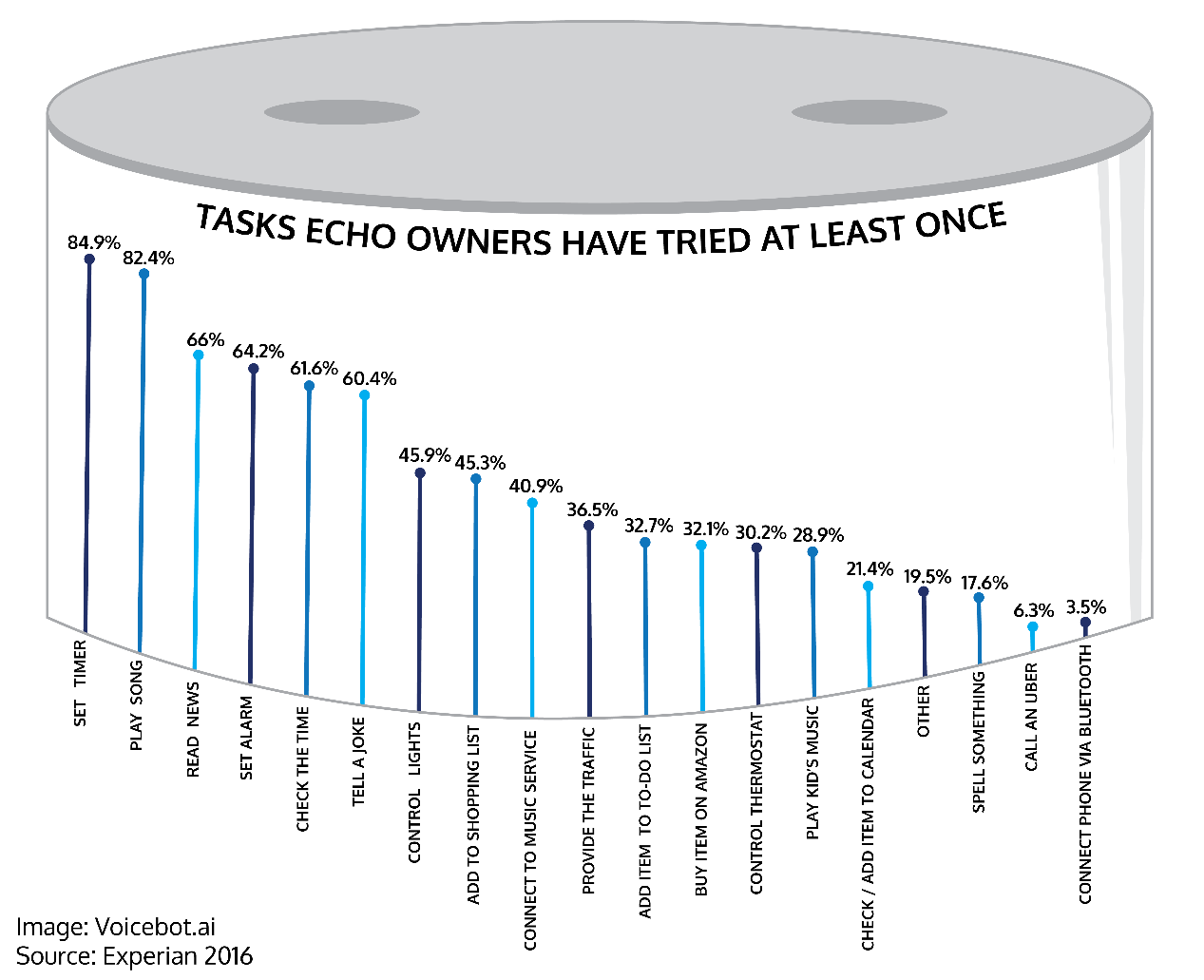

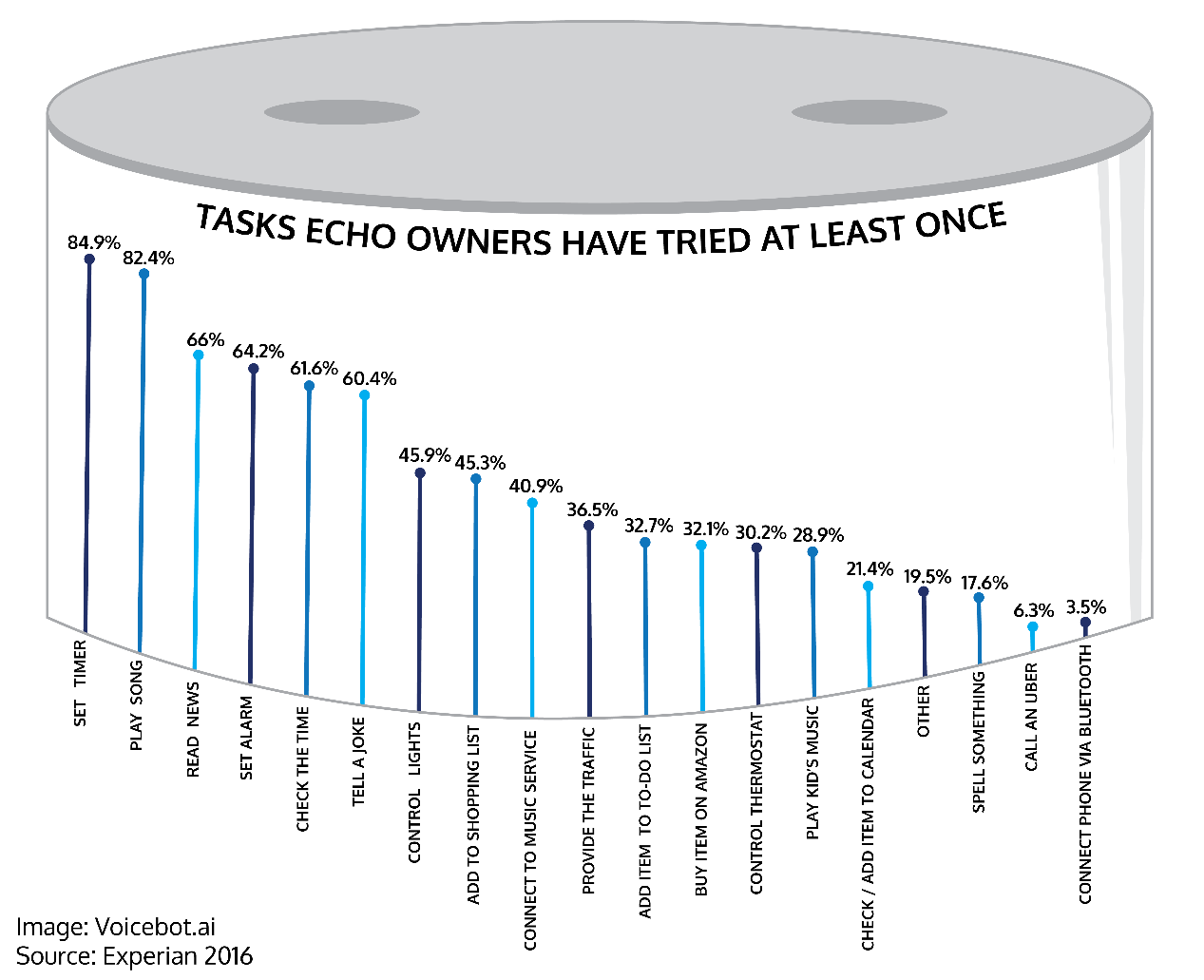

人們都請Alexa做什麼,從左至右:計時、播音樂、讀新聞、設鬧鐘、報時、『說笑話60.4%』、調控燈光、……(圖片來源:https://voicebot.ai/amazon-echo-alexa-stats/)

人們都請Alexa做什麼,從左至右:計時、播音樂、讀新聞、設鬧鐘、報時、『說笑話60.4%』、調控燈光、……(圖片來源:https://voicebot.ai/amazon-echo-alexa-stats/)

「糖醋魚」的例子其實在很多美國家庭都發生過,而中國的「智慧宅」也越來越多。那個「呃」其實更是重大突破。Google最近公開Duplex語音技術,並因為好幾次不被拆穿是機器人而順利預約理髮、點餐,而據此稱通過了「圖靈測試(Turing test)」,聲名大噪。在一分鐘與理髮師喬時間的斡旋中,正是因為機器人會模仿人類如「嗯(hmm)」、「呃(uh)」等語癖,讓人以為它真是人。這代表了人工智慧更上一層樓了,「自然語言」處理效能越來越強、人類將會越來越信賴語音助理。

根據Gartner、Edison Research、CIRP、KPCB和InfoScout,2017全世界有3400萬個VPA(虛擬個人助手)裝置,到2020美國75%家庭都會有至少一個智慧語音裝置。如果這還不夠嚇人,有個公司叫Liveperson正在讓講到一半的話可以「隨時帶著走(on-the-go)」。它推出LiveEngage服務,與商務語音平台合作,如Google的Rich Communication Service和蘋果的Apple Business Chat,利用人工智慧技術將人與機器的對話「無縫接軌」。例如開會開到一半有急事,可以直接在開車時讓機器人遠端繼續開會,因為客製化機器人已經「學過」你的語言了。你的一段重要對話可以隨身持續:在家用Alexa,出門用Siri,公司用Google Assistant,重點是你不用按下任何「啟動鍵」,也不用打開手機或電腦,只要開門、上車、通勤,以及「講話」就行了。

智慧語音技術大餅越來越大,從左起的微軟、蘋果、亞馬遜、谷歌到臉書,世界資訊龍頭都在全心投入這幾乎能代表人工智慧尖峰的技術(圖片來源:http://readmultiplex.com/2017/01/10/the-voice-first-abstraction-layers-the-startup-opportunity/)

智慧語音技術大餅越來越大,從左起的微軟、蘋果、亞馬遜、谷歌到臉書,世界資訊龍頭都在全心投入這幾乎能代表人工智慧尖峰的技術(圖片來源:http://readmultiplex.com/2017/01/10/the-voice-first-abstraction-layers-the-startup-opportunity/)

我們說的話,能被機器理解好像已經很自然了。60年前,圖靈測試的發明者艾倫.圖靈(Alan Turing),曾預言在2000年電腦程式能讓30%人類至少相信其5分鐘「為人」。現在似乎十分靈驗,而超級人工智慧更能「迷倒眾生」。但機器真的能學會跟人類「掏心掏肺」嗎?事實上至今為止,尚無真正能用完全自然語言與人類對話的AI,亦即,現今最強的AI也仍是「弱人工智慧(weak AI)」。弱AI可以做很多「應用性(applied)」強的事情,如:幫醫師比對大量「疑有癌症細胞的照片(有的話亮度高於X)」;如今可說所有AI都屬於「應用性AI(applied AI)」。但沒有AI能「聽出病人的心聲」,而依此做出最人道的決定。

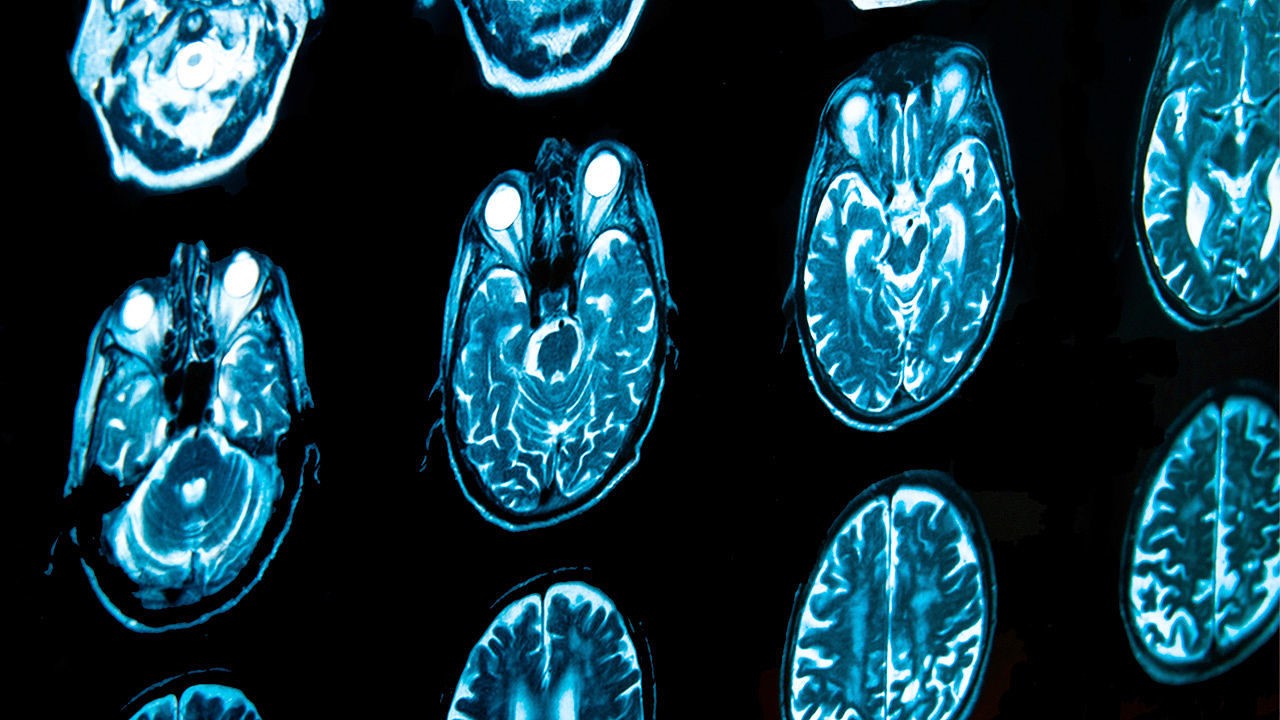

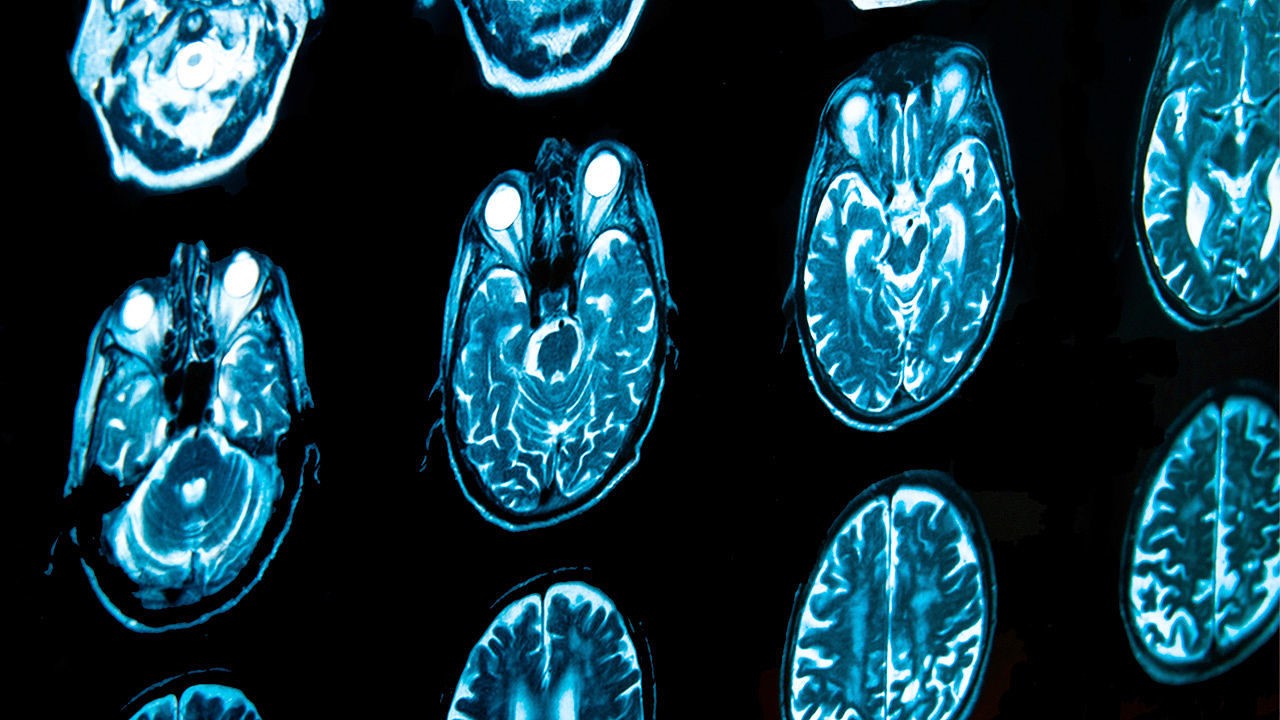

IBM的超級AI能幫忙分析腦癌斷層掃描圖,比人類還快狠準(圖片來源:https://www.emaze.com/@AWWLFWRQ/IBM-Watson-copy2)

IBM的超級AI能幫忙分析腦癌斷層掃描圖,比人類還快狠準(圖片來源:https://www.emaze.com/@AWWLFWRQ/IBM-Watson-copy2)

AI之所以能夠在有規則的事情上達到第一,如:圍棋或德州撲克,是因為「完美資訊(perfect information)」很多、很好的邏輯分析、分析目的簡單:贏(使最佳化結果為『+(勝)』而不為『-(負)』),或累積最多獎金(數字越大越好)。弱AI就算記住所有人類「語癖」,這些「呃、嗯、讓我想想…」也是事先「挑好」的,其目的是讓機器多一點時間找尋「最佳解答」。但很多時候人的語癖是為了「迴避問題」、因為「害羞」,或純粹出於「沒睡飽」。

人類語言之所以自然,是因為人有感情,而感情使我們的語言屬於「不完美資訊(imperfect information)」。正如老話:「人因不完美而完美」。那我們需要「不完美的機器」應用在哪?真正「完全人工智慧(full AI)」會聽得懂「諷刺」、能了解「隱喻」、猜得出「欺騙」、不小心「口誤」。而當機器真能了解文學家歌德(J. W. Goethe)所言:「知道是不夠的, 我們應當應用。意願是不夠的,我們應當行動(Knowing is not enough, we must apply. Willing is not enough, we must do)」,它們會不會覺得只當人類的「小幫手」是不夠的,應當有所「行動」了呢?

總編輯:國立中山大學資訊工程學系 黃英哲教授

副總編輯:國立中山大學外國語文學系 徐淑瑛教授

(本文由科技部補助「新媒體科普傳播實作計畫」執行團隊撰稿)

人們都請Alexa做什麼,從左至右:計時、播音樂、讀新聞、設鬧鐘、報時、『說笑話60.4%』、調控燈光、……(圖片來源:https://voicebot.ai/amazon-echo-alexa-stats/)

人們都請Alexa做什麼,從左至右:計時、播音樂、讀新聞、設鬧鐘、報時、『說笑話60.4%』、調控燈光、……(圖片來源:https://voicebot.ai/amazon-echo-alexa-stats/) 智慧語音技術大餅越來越大,從左起的微軟、蘋果、亞馬遜、谷歌到臉書,世界資訊龍頭都在全心投入這幾乎能代表人工智慧尖峰的技術(圖片來源:http://readmultiplex.com/2017/01/10/the-voice-first-abstraction-layers-the-startup-opportunity/)

智慧語音技術大餅越來越大,從左起的微軟、蘋果、亞馬遜、谷歌到臉書,世界資訊龍頭都在全心投入這幾乎能代表人工智慧尖峰的技術(圖片來源:http://readmultiplex.com/2017/01/10/the-voice-first-abstraction-layers-the-startup-opportunity/) IBM的超級AI能幫忙分析腦癌斷層掃描圖,比人類還快狠準(圖片來源:https://www.emaze.com/@AWWLFWRQ/IBM-Watson-copy2)

IBM的超級AI能幫忙分析腦癌斷層掃描圖,比人類還快狠準(圖片來源:https://www.emaze.com/@AWWLFWRQ/IBM-Watson-copy2)