115/01/07

傳承傳統技藝的薪火,點亮偏鄉學子心中的科學火花

巫衍儒|

科技大觀園特約編輯

前言

張量處理器(Tensor Processing Unit,TPU)是Google公司為機器學習所開發的特殊專用處理器。在2016年的Google I/O年會上首次公布了TPU,不過在這之前,Google街景服務及世界棋王AlphaGo等知名的應用程式與研究中,都使用到了TPU。那為什麼要研發這個處理晶片呢?

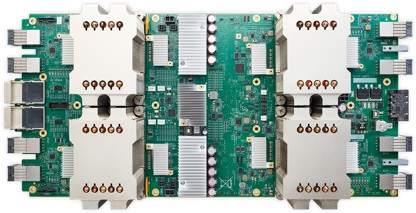

AlphaGo使用配有TPU的伺服器(圖片來源:https://cloudplatform.googleblog.com/)

AlphaGo使用配有TPU的伺服器(圖片來源:https://cloudplatform.googleblog.com/)更有效地處理任務–TPU的誕生

結語

副總編輯:國立中山大學資訊工程學系 陳坤志教授

總編輯:國立中山大學資訊工程學系 黃英哲教授

(本文由科技部補助「新媒體科普傳播實作計畫」執行團隊撰稿)