演化?革命?

從 2014 年以來,隨著許多大企業、新創公司與國家巨大資源的投入,自駕車已經變成一個熱門的課題。網路上有許多相關的探討,除了科學技術面,同時也涵蓋了與自駕車商務法律道德相連的議題。

為何文章的標題前段是「演化(革命)」呢?。英文中演化 (Evolution) 與革命 (Revolution) 只差一個字母 R。在自駕車核心技術的發展上,目前並還沒有收斂到一個大家都同意的作法,還無法判定哪些技術是演化,哪些技術會是破壞式革命,但如果我們把時間軸拉長來看,革命或許只是變化較大的演化而已。我們試圖不去重複讀者可以在網路上獲取的資訊,而以討論自駕車一些比較有趣或是有爭議性的問題來了解自駕車的核心技術。這邊也請讀者以保持懷疑的態度來審視這些論點,因為幾年內可能有些問題會以革命式的技術、方式解決,當然現在有些論點也可能不再適用。

自駕車是「電腦加上輪子」還是「車輛加上電腦」?

從硬體上來看,自駕車是一個車輛、電腦、晶片與各式感測器高度整合的系統。從車輛產業來看,自駕車自然是車輛加上電腦;而從資通訊半導體產業來看,自駕車則是電腦再加上四個輪子。早期 Google(其自駕車部門已經獨立出來成為 Waymo)開發自駕車技術時,是以電腦加上四個輪子這個方針來打造自駕車,但在車輛生產製造上並不順利,現在則改為與一線車廠合作。而要在傳統車廠內,建立一支自駕軟體團隊亦不容易。現在一線車廠多與自駕車新創公司合作,或是購入自駕車新創但讓其自主運作。當然也有資通訊半導體產業購入自駕車新創使其在未來自駕車商業版圖上建立自己的灘頭堡。特斯拉 (Tesla) 則是少數直接跳脫「電腦加輪子」或是「車輛加電腦」的本位路線之爭,直接進行電動車與自駕車高度軟硬體系統整合的雙箭頭攻擊。現今特斯拉的成功也逼得傳統車廠、車用電子與資通訊產業不得不迎頭趕上。

要好好整合車輛系統與資通訊技術並不容易。除了技術發展的習慣與文化不同外,不管在硬體上或是軟體上,往往是牽一髮而動全身的。在車輛加上一個新的硬體或是軟體功能,相關的測試、驗證與量產所需時間往往是三年起跳。在龐大的自駕車軟體上要加上一個新功能也不見得容易,常常也涉及模組重寫或是整個軟體架構重新設計。自駕車系統開發需要所有車輛、自駕車軟體與相關軟硬體工程師在合理有效的規劃下緊密地合作。

自駕車一定是電動車嗎?

其實自駕車並不侷限在電動車,我們可將自駕系統搭建在各種車輛上。當然自駕車電腦與感測器需要一個穩定的電源供應,這也有方法讓「非電動車」的車輛可以提供穩定電源。目前已有越來越多的各式車輛往電動化的方向進展,而氫燃料電池也是一個受重視的發展方向。車輛自駕化跟這些方向並沒有任何衝突。

圖一:工研院機械所自駕車車隊。圖/交通大學教授王傑智提供

自駕車的軟體就是大家說的AI嗎?

目前多數的自駕車團隊裡的軟體有四大模組:車輛定位(地圖建構)、物件偵測辨識追蹤、移動物件預測、車輛決策控制。

1. 車輛定位模組:主要任務為根據自駕車高精地圖與自駕車感測器所收集到的數據來精準地估測車輛的位置與姿態。圖一截自研究團隊在桃園國際機場所進行的定位系統驗證的影片。定位系統的精準度,往往直接影響基本的車輛控制性能。一個精準的地圖、定位與車控整合系統可以讓自駕車看起來就像捷運車輛一樣,在一個虛擬的軌道中精準的行進著。

但是自駕車並不是在一個封閉的軌道場域運行,因此自駕車還要有感知周遭環境的能力。

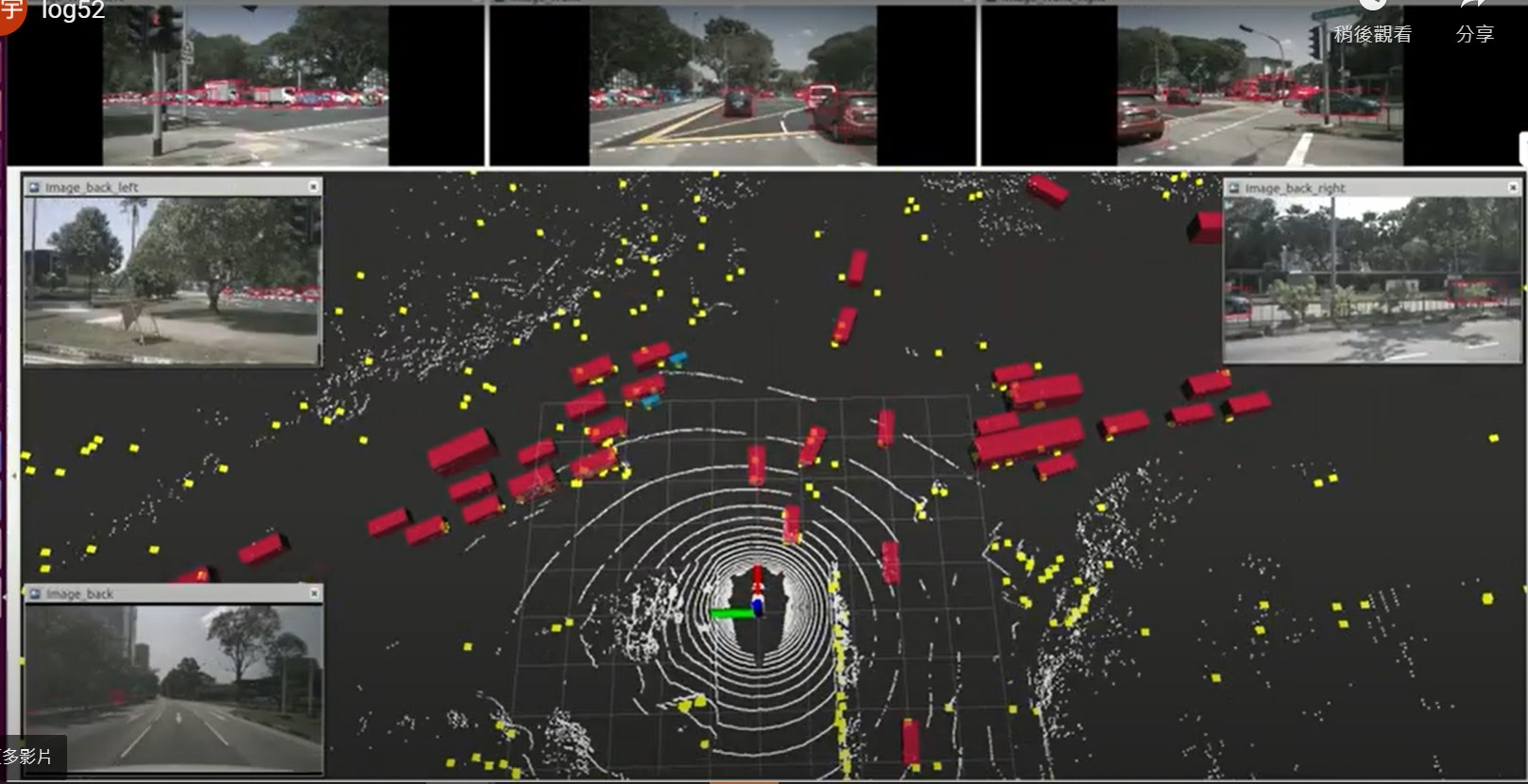

2. 物件偵測辨識追蹤模組:主要任務是處理來自各種感測器 (相機、光達與雷達) 的資料,來估測在車輛周遭環境的各種狀態。圖三截自一影片,所展示內容為一個自駕車開放數據庫 (nuScenes) 中各種感測器數據,六個相機的數據中還有其對應的各種物體標記。在影片正中央中,較小白點是光達數據,較大的黃點則是五個車用雷達的數據,對應的各種物體標記亦以各種大小的長方體表示。

圖三:物件偵測辨識追蹤模組範例。圖/nuScenes數據庫,新加坡,晴天

3. 移動物件預測:只是偵測辨識追蹤周遭物件還不夠,自駕車還要能預測周遭移動物件未來五至十秒內的動態,以便能讓決策控制模組決定最佳的操縱與控制策略。目前深度學習是被用來完成物件偵測、辨識與預測的主流方法。一般大家口中自駕車的 AI 通常是指用在這裡的深度學習。

4. 決策控制系統:根據所設目標、任務與感知系統所提供周遭環境的狀態估測,決定車輛路線規劃與行車策略。在考慮車輛動態性能下,具體下達控制指令,完成決策系統所下達的命令。跟捷運車輛比起來,自駕車的決策控制複雜很多。而要在台灣運行的自駕車則要處理比起歐美國家更複雜的交通狀況。讀者可觀看研究團隊在新竹南寮的自駕車測試驗證影片。

另外也有團隊主張不要區分這些模組,直接以深度學習完成所有自駕車感知、預測與決策功能。但這個路線目前並不是很成功,還需要更大的突破與進展。

自駕車一定要用到所有的感測器嗎?

自駕車用來感知周遭環境的感測器主要有相機、光達與雷達。雷達主要用測量與前方車輛的距離與相對速度,用來計算車輛需要維持速度、加速還是減速煞車,進一步對車控電腦下達控制縱向運動的命令。相機主要則用來偵測車道線,計算出方向盤所需移動的角度及角速度來維持車輛在車道中行駛不壓線。

以雷達與相機在有清楚車道線且交通狀況相對簡單的高速公路路段來實施自駕已足夠,越來越多的車廠追隨特斯拉腳步來提供先進輔助駕駛的功能。這邊有兩點需要留意:1)這些先進輔助駕駛系統並不是全自駕系統,人類駕駛還是要隨時注意路況,並在緊急情況下隨時接管。2)城市低速自駕遠比高速公路快速自駕困難。車輛的高低速控制並不是問題,主要的挑戰是城市多樣多變的交通狀況、感知系統的精準度與控制策略的複雜與合宜度。

雖然特斯拉堅信以深度學習來處理相機的數據已經足夠產出高速公路與城市自駕所需要的感知能力,但多數的自駕團隊還是把光達當作自駕車感測器主力之一,其中 Waymo 已經在多個城市中驗證全自駕系統的效能與安全性,但特斯拉的系統目前還是無法有效在城市中使用。目前自駕車採用光達的障礙主要是其成本太高,以及硬體不能滿足車規要求。雷達在這自駕車感測器之戰中,似乎不受重視或只是淪為配角,但其全天候均可使用的特性,與未來更高解析度、立體的新雷達或許會讓整個戰局改觀。由於這些感測器具有不同的特性,與其說是互相競爭,倒不如說是互補的,基於安全性的考量下,未來的自駕車產品應不會摒棄任一有效的感測器,例如先前以相機為主要感測器的 Mobileye 公司亦開始研發與使用光達。對自駕車這個安全第一的系統而言,使用所有有效的感測器或許是必然的方向。

我們應該要學什麼才能做自駕車?

前面我們說做好自駕車必須好好整合車輛系統與資通訊技術,但是這並不是意味著我們這些都要學才能做好自駕車,畢竟全世界也沒有幾個人能同時擁有這麼多的知識與技能。

你如果對資訊工程有興趣,程式語言、演算法、線性代數、機器人學、電腦視覺、人工智慧、機器學習、軟體工程的課程都很有用。你如果對電機工程有興趣,除了與資訊工程相似的課程外,控制理論、最佳化理論、系統工程、半導體、通訊等學科亦在自駕車系統中扮演重要角色。當然也可以在機械工程、車輛工程中,學到車輛系統與車輛控制的專業。

除了培養專業知識外,學會與不同領域專家一同打造一個(自駕車)系統的態度與方法也是非常重要。

台灣這幾年將有好幾個自駕車的實證計畫在各地實施,我們或許很難預測革命式的技術創造,但可以保持一顆開放的心來了解、接受新科技與新方法,一起以積極的方式來創造未來、迎向未來。

本著作係採用 創用 CC 姓名標示─非商業性─禁止改作 3.0 台灣 授權條款 授權.

本授權條款允許使用者重製、散布、傳輸著作,但不得為商業目的之使用,亦不得修改該著作。 使用時必須按照著作人指定的方式表彰其姓名。

閱讀授權標章或

授權條款法律文字。